| Introduction | Structures planétaires | Observables | Techniques et méthodes | Lieux de vie | Auteurs | Boite à outils |

Loi du chi 2 |

Nous nous sommes toujours ramenés à des modèles du type: modèle déterministe + bruit gaussien. Afin de vérifier que les observations sont compatibles avec le modèle, on étudie les résidus, définis comme "les observation - le modèle ajusté".

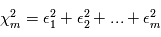

La loi du  est un outil commode pour étudier le comportement de plusieurs variables gaussiennes. Considérons d'abord une famille de

est un outil commode pour étudier le comportement de plusieurs variables gaussiennes. Considérons d'abord une famille de  variables aléatoires gaussiennes indépendantes

variables aléatoires gaussiennes indépendantes  , de moyenne nulle et de variance unité. On forme la quantité

, de moyenne nulle et de variance unité. On forme la quantité  . Comme les

. Comme les  sont des variables aléatoires, les

sont des variables aléatoires, les  le sont aussi. La somme de variables alétoires étant toujours une variable alétoire,

le sont aussi. La somme de variables alétoires étant toujours une variable alétoire,  suit une certaine loi de probabilité. Dans l'analogie avec un programme informatique, la variable alétoire

suit une certaine loi de probabilité. Dans l'analogie avec un programme informatique, la variable alétoire  se comporte comme un programme qui appelle

se comporte comme un programme qui appelle  programmes générant une variables gaussiennes, puis additionne leurs carrés. Elle est appelée loi du

programmes générant une variables gaussiennes, puis additionne leurs carrés. Elle est appelée loi du à m degrés de liberté. On peut montrer qu'en moyenne une variable gaussienne au carré

à m degrés de liberté. On peut montrer qu'en moyenne une variable gaussienne au carré  a une moyenne de 1. En conséquence,

a une moyenne de 1. En conséquence,  vaudra typiquement

vaudra typiquement  .

.

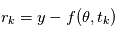

Pourquoi cette loi serait utile pour notre cas ? Si le modèle est bien ajusté, les résidus doivent se comporter comme un bruit gaussien. En supposant que les erreurs sont toutes indépendantes, de moyenne nulle et de variance unité, les résidus  en sont une réalisation. Donc

en sont une réalisation. Donc  est une réalisation d'une loi du

est une réalisation d'une loi du  à

à  degrés de liberté. Si

degrés de liberté. Si  est de l'ordre de

est de l'ordre de  , le modèle est cohérent. Sinon, le modèle ou les paramètres ajustés sont à revoir.

, le modèle est cohérent. Sinon, le modèle ou les paramètres ajustés sont à revoir.

En pratique, les erreurs  ne sont évidemment pas de variance unité et parfois pas indépendantes. Par contre on peut à bon droit supposer qu'elles sont de moyenne nulle. Pour se ramener au cas précédent, on calcule non pas une réalisation de

ne sont évidemment pas de variance unité et parfois pas indépendantes. Par contre on peut à bon droit supposer qu'elles sont de moyenne nulle. Pour se ramener au cas précédent, on calcule non pas une réalisation de  mais de

mais de  où

où  ,

,  est sa transposée et

est sa transposée et  est la matrice des variances-covariances de

est la matrice des variances-covariances de  . Dans le cas où les

. Dans le cas où les  sont indépendantes, la matrice des variances-covariances est diagonale, son

sont indépendantes, la matrice des variances-covariances est diagonale, son  -ème terme diagonal étant

-ème terme diagonal étant  , soit l'inverse de la variance de

, soit l'inverse de la variance de  .

.