| Introduction | Structures planétaires | Observables | Techniques et méthodes | Lieux de vie | Auteurs | Boite à outils |

Traitement statistique |

Rappelons qu'une variable aléatoire peut être vue comme un programme informatique qui délivre des valeurs suivant une certaine distribution de probabilité lorsqu'on lui demande. Le problème que nous posons maintenant est équivalent au suivant. Supposons qu'un ordinateur ait en mémoire des paramètres  (nombre de planètes, leurs caractéristiques orbitales, la période de rotation de l'étoile etc.). S'il n'y avait pas de bruit, une mesure à l'instant

(nombre de planètes, leurs caractéristiques orbitales, la période de rotation de l'étoile etc.). S'il n'y avait pas de bruit, une mesure à l'instant  reviendrait à demander à l'ordinateur d'évaluer une fonction

reviendrait à demander à l'ordinateur d'évaluer une fonction  . Nous connaissons

. Nous connaissons  et

et  (c'est l'un des modèles de la page précédente), mais nous ne connaissons pas

(c'est l'un des modèles de la page précédente), mais nous ne connaissons pas  . Notre but est de le déterminer à partir des mesures

. Notre but est de le déterminer à partir des mesures  . Ce principe est similaire à la résolution d'une énigme: quelqu'un connaît une information

. Ce principe est similaire à la résolution d'une énigme: quelqu'un connaît une information  et nous essayons de la deviner en posant une question. Dans le cas sans bruit, celui qui pose l'énigme ne nous induit pas en erreur, mais cela ne veut pas dire que la résolution est facile !

et nous essayons de la deviner en posant une question. Dans le cas sans bruit, celui qui pose l'énigme ne nous induit pas en erreur, mais cela ne veut pas dire que la résolution est facile !

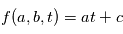

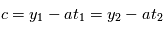

Exemple: on veut trouver les paramètres d'une fonction affine du temps  (ici

(ici  ). On évalue la valeur de

). On évalue la valeur de  en

en  , on obtient

, on obtient  : on a deux inconnues pour une équation, on ne peut pas résoudre. Si on a

: on a deux inconnues pour une équation, on ne peut pas résoudre. Si on a  , avec

, avec  , alors on a

, alors on a  et

et  .

.

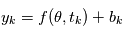

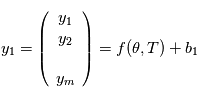

Notre cas est plus compliqué. Les valeurs que nous obtenons sont  où

où  est la réalisation d'une variable aléatoire

est la réalisation d'une variable aléatoire  . A l'appel numéro

. A l'appel numéro  du programme, l'ordinateur fait appel à un autre programme qui délivre une variable alétoire selon une certaine loi. En l'occurrence, nous supposons cette loi gaussienne. Si nous faisons

du programme, l'ordinateur fait appel à un autre programme qui délivre une variable alétoire selon une certaine loi. En l'occurrence, nous supposons cette loi gaussienne. Si nous faisons  mesures, tout se passe comme si un programme principal évaluait la fonction

mesures, tout se passe comme si un programme principal évaluait la fonction  et

et  programmes secondaires

programmes secondaires  ,

,  retournent chacun une valeur

retournent chacun une valeur  . Si nous pouvions remonter le temps et faire les mesures plusieurs fois aux mêmes instants, on aurait des des vecteurs de mesures

. Si nous pouvions remonter le temps et faire les mesures plusieurs fois aux mêmes instants, on aurait des des vecteurs de mesures  , puis

, puis  etc. (notez qu'ici

etc. (notez qu'ici  et

et  sont des vecteurs.

sont des vecteurs.

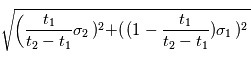

Comme nous ne connaissons que la loi suivie par les variables  , ils nous est impossible de connaître les paramètres avec certitude. On leur attache une "erreur", qui quantifie l'incertitude que l'on a sur eux. En reprenant l'exemple précédent on mesure

, ils nous est impossible de connaître les paramètres avec certitude. On leur attache une "erreur", qui quantifie l'incertitude que l'on a sur eux. En reprenant l'exemple précédent on mesure  et

et  . Si on estime

. Si on estime  et

et  avec les mêmes formules, on fera une erreur

avec les mêmes formules, on fera une erreur  sur

sur  et une erreur

et une erreur  sur

sur  (admis).

(admis).